Bonjour,

j’ai un probleme sur un RAID1 que j’utilise pour mon OS OpenMediaVault qui tourne sous debian 11.

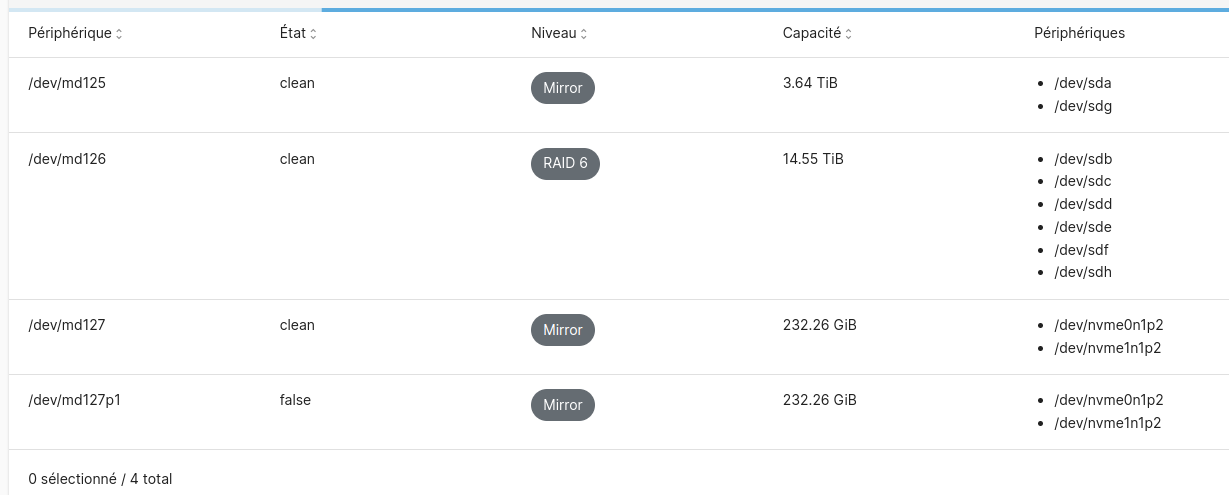

Après configuration je me retrouve dans la situation suivante:

le volume RAID1 est fait avec 2 SSD NVME

tout est fonctionnel mais OMV voit 2 arrays, dont 1 en staut « false »

voilà quelques infos:

cat /proc/mdstat

Personalities : [raid1] [raid6] [raid5] [raid4] [linear] [multipath] [raid0] [raid10]

md125 : active raid1 sda[0] sdg[2]

3906886464 blocks super 1.2 [2/2] [UU]

bitmap: 0/30 pages [0KB], 65536KB chunk

md126 : active raid6 sdb[7] sdh[6] sdd[5] sdf[8] sde[4] sdc[1]

15627554816 blocks super 1.2 level 6, 512k chunk, algorithm 2 [6/6] [UUUUUU]

bitmap: 0/30 pages [0KB], 65536KB chunk

md127 : active raid1 nvme0n1p2[1] nvme1n1p2[0]

243540992 blocks super 1.2 [2/2] [UU]

bitmap: 2/2 pages [8KB], 65536KB chunk

ou encore:

jerome@DTC-JEJE:/$ lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 1 3,6T 0 disk

└─md125 9:125 0 3,6T 0 raid1 /srv/dev-disk-by-uuid-e5954363-9d99-4c6f-9dd6-7c2ca9fc4d9e

sdb 8:16 1 3,6T 0 disk

└─md126 9:126 0 14,6T 0 raid6 /srv/dev-disk-by-uuid-7cad0e2e-e1e9-49f9-bb3d-07c5de338a9e

sdc 8:32 1 3,6T 0 disk

└─md126 9:126 0 14,6T 0 raid6 /srv/dev-disk-by-uuid-7cad0e2e-e1e9-49f9-bb3d-07c5de338a9e

sdd 8:48 0 3,6T 0 disk

└─md126 9:126 0 14,6T 0 raid6 /srv/dev-disk-by-uuid-7cad0e2e-e1e9-49f9-bb3d-07c5de338a9e

sde 8:64 0 3,6T 0 disk

└─md126 9:126 0 14,6T 0 raid6 /srv/dev-disk-by-uuid-7cad0e2e-e1e9-49f9-bb3d-07c5de338a9e

sdf 8:80 0 3,6T 0 disk

└─md126 9:126 0 14,6T 0 raid6 /srv/dev-disk-by-uuid-7cad0e2e-e1e9-49f9-bb3d-07c5de338a9e

sdg 8:96 0 3,6T 0 disk

└─md125 9:125 0 3,6T 0 raid1 /srv/dev-disk-by-uuid-e5954363-9d99-4c6f-9dd6-7c2ca9fc4d9e

sdh 8:112 0 3,6T 0 disk

└─md126 9:126 0 14,6T 0 raid6 /srv/dev-disk-by-uuid-7cad0e2e-e1e9-49f9-bb3d-07c5de338a9e

nvme1n1 259:0 0 232,9G 0 disk

├─nvme1n1p1 259:1 0 512M 0 part /boot/efi2

└─nvme1n1p2 259:2 0 232,4G 0 part

└─md127 9:127 0 232,3G 0 raid1

└─md127p1 259:6 0 232,3G 0 part /

nvme0n1 259:3 0 232,9G 0 disk

├─nvme0n1p1 259:4 0 512M 0 part /boot/efi

└─nvme0n1p2 259:5 0 232,4G 0 part

└─md127 9:127 0 232,3G 0 raid1

└─md127p1 259:6 0 232,3G 0 part /

vous avez une idée pour nettoyer cette config?

Merci