Merci PascalHambourd pour ton retour, malgré ton agacement

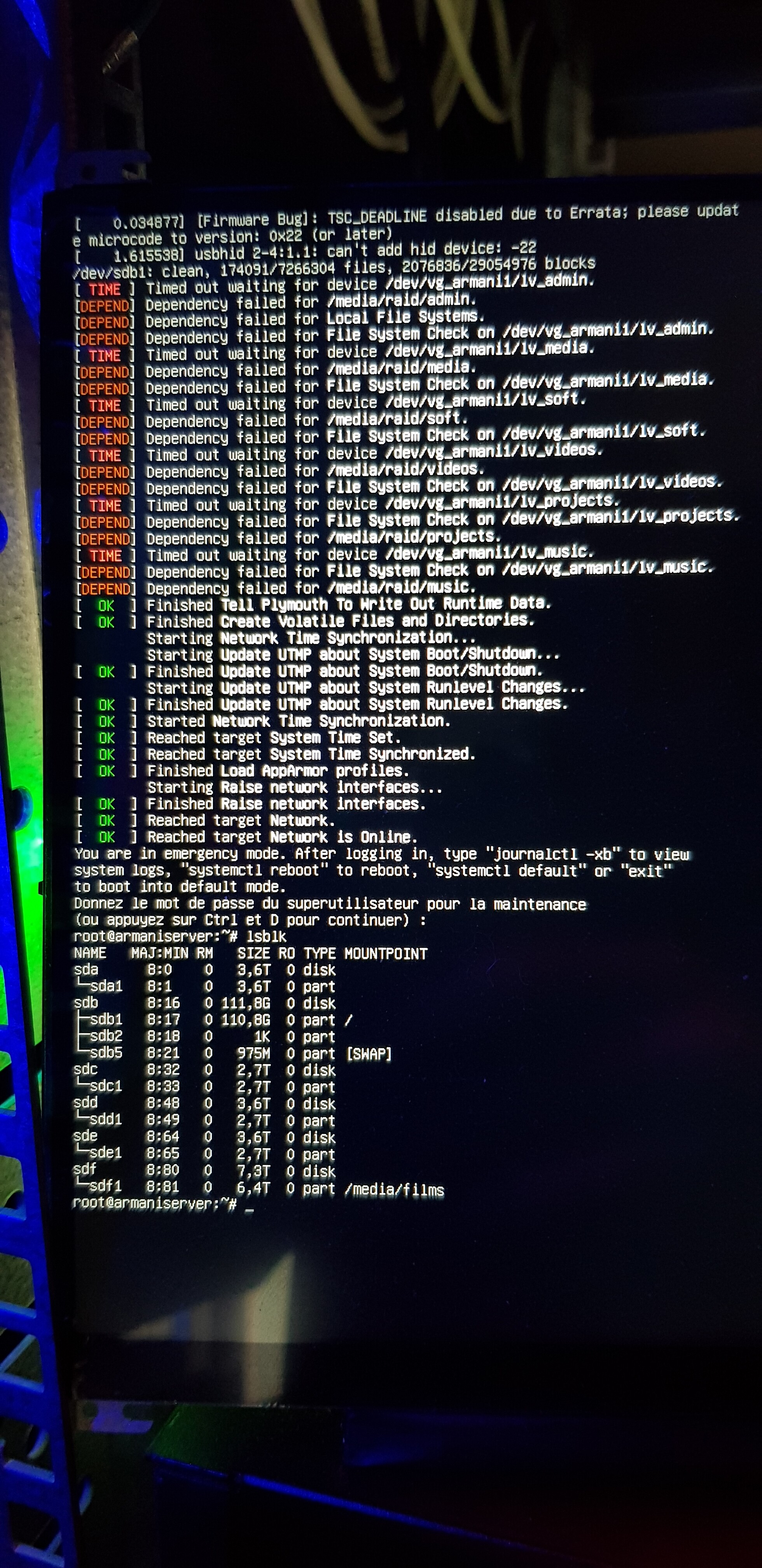

Désolé pour la photo.

J’ai donc maintenant accès en SSH grâce au « nofail » !

Voici ce que donne les cdes:

cat /proc/mdstat

Personalities : [linear] [multipath] [raid0] [raid1] [raid6] [raid5] [raid4] [raid10]

unused devices: <none>

cat /etc/mdadm/mdadm.conf

# mdadm.conf

#

# !NB! Run update-initramfs -u after updating this file.

# !NB! This will ensure that initramfs has an uptodate copy.

#

# Please refer to mdadm.conf(5) for information about this file.

#

# by default (built-in), scan all partitions (/proc/partitions) and all

# containers for MD superblocks. alternatively, specify devices to scan, using

# wildcards if desired.

#DEVICE partitions containers

# automatically tag new arrays as belonging to the local system

HOMEHOST <system>

# instruct the monitoring daemon where to send mail alerts

MAILADDR root

# definitions of existing MD arrays

ARRAY /dev/md/0 metadata=1.2 UUID=6f03be00:1bc6f3f8:00be90d5:bb36b52e name=armaniserver:0

# This configuration was auto-generated on Mon, 30 Oct 2023 13:27:02 +0100 by mkconf

ARRAY /dev/md/0 metadata=1.2 UUID=6f03be00:1bc6f3f8:00be90d5:bb36b52e name=armaniserver:0

mdadm --examine --scan --verbose

ARRAY /dev/md/0 level=raid5 metadata=1.2 num-devices=5 UUID=6f03be00:1bc6f3f8:00be90d5:bb36b52e name=armaniserver:0

devices=/dev/sdb1,/dev/sdc1,/dev/sde1,/dev/sdd1

mdadm --examine /dev/sd[bcde]1

/dev/sdb1:

Magic : a92b4efc

Version : 1.2

Feature Map : 0x1

Array UUID : 6f03be00:1bc6f3f8:00be90d5:bb36b52e

Name : armaniserver:0 (local to host armaniserver)

Creation Time : Fri Oct 21 05:41:37 2022

Raid Level : raid5

Raid Devices : 5

Avail Dev Size : 7813774991 (3725.90 GiB 4000.65 GB)

Array Size : 11718217728 (11175.36 GiB 11999.45 GB)

Used Dev Size : 5859108864 (2793.84 GiB 2999.86 GB)

Data Offset : 260096 sectors

Super Offset : 8 sectors

Unused Space : before=260016 sectors, after=1954666127 sectors

State : clean

Device UUID : c933de3e:af41990f:9f9beb8b:8211a920

Internal Bitmap : 8 sectors from superblock

Update Time : Sat Jan 6 22:38:32 2024

Bad Block Log : 512 entries available at offset 24 sectors

Checksum : 483a0965 - correct

Events : 49761

Layout : left-symmetric

Chunk Size : 512K

Device Role : Active device 0

Array State : AAAA. ('A' == active, '.' == missing, 'R' == replacing)

/dev/sdc1:

Magic : a92b4efc

Version : 1.2

Feature Map : 0x1

Array UUID : 6f03be00:1bc6f3f8:00be90d5:bb36b52e

Name : armaniserver:0 (local to host armaniserver)

Creation Time : Fri Oct 21 05:41:37 2022

Raid Level : raid5

Raid Devices : 5

Avail Dev Size : 5859112960 (2793.84 GiB 2999.87 GB)

Array Size : 11718217728 (11175.36 GiB 11999.45 GB)

Used Dev Size : 5859108864 (2793.84 GiB 2999.86 GB)

Data Offset : 260096 sectors

Super Offset : 8 sectors

Unused Space : before=260016 sectors, after=4096 sectors

State : clean

Device UUID : 41d47cca:70607f0f:3f251610:d63345ef

Internal Bitmap : 8 sectors from superblock

Update Time : Sat Jan 6 22:38:32 2024

Bad Block Log : 512 entries available at offset 24 sectors

Checksum : b203adff - correct

Events : 49761

Layout : left-symmetric

Chunk Size : 512K

Device Role : Active device 1

Array State : AAAA. ('A' == active, '.' == missing, 'R' == replacing)

/dev/sdd1:

Magic : a92b4efc

Version : 1.2

Feature Map : 0x1

Array UUID : 6f03be00:1bc6f3f8:00be90d5:bb36b52e

Name : armaniserver:0 (local to host armaniserver)

Creation Time : Fri Oct 21 05:41:37 2022

Raid Level : raid5

Raid Devices : 5

Avail Dev Size : 5859112960 (2793.84 GiB 2999.87 GB)

Array Size : 11718217728 (11175.36 GiB 11999.45 GB)

Used Dev Size : 5859108864 (2793.84 GiB 2999.86 GB)

Data Offset : 260096 sectors

Super Offset : 8 sectors

Unused Space : before=260016 sectors, after=4096 sectors

State : clean

Device UUID : dad83f7f:50dd51b5:989e0478:f607da59

Internal Bitmap : 8 sectors from superblock

Update Time : Sat Jan 6 22:38:32 2024

Bad Block Log : 512 entries available at offset 24 sectors

Checksum : df1c7d4a - correct

Events : 49761

Layout : left-symmetric

Chunk Size : 512K

Device Role : Active device 2

Array State : AAAA. ('A' == active, '.' == missing, 'R' == replacing)

/dev/sde1:

Magic : a92b4efc

Version : 1.2

Feature Map : 0x1

Array UUID : 6f03be00:1bc6f3f8:00be90d5:bb36b52e

Name : armaniserver:0 (local to host armaniserver)

Creation Time : Fri Oct 21 05:41:37 2022

Raid Level : raid5

Raid Devices : 5

Avail Dev Size : 5859112960 (2793.84 GiB 2999.87 GB)

Array Size : 11718217728 (11175.36 GiB 11999.45 GB)

Used Dev Size : 5859108864 (2793.84 GiB 2999.86 GB)

Data Offset : 260096 sectors

Super Offset : 8 sectors

Unused Space : before=260016 sectors, after=4096 sectors

State : clean

Device UUID : 74d16a0d:b4f1b611:c318a24a:f48df20d

Internal Bitmap : 8 sectors from superblock

Update Time : Sat Jan 6 22:38:32 2024

Bad Block Log : 512 entries available at offset 24 sectors

Checksum : 50628a1a - correct

Events : 49761

Layout : left-symmetric

Chunk Size : 512K

Device Role : Active device 3

Array State : AAAA. ('A' == active, '.' == missing, 'R' == replacing)

mdadm --detail /dev/md*

mdadm: cannot open /dev/md*: No such file or directory

mdadm --detail /dev/md0

mdadm: cannot open /dev/md0: No such file or directory

mdadm --detail /dev/md/0

mdadm: cannot open /dev/md/0: No such file or directory

Les disques semblent sains.