Merci Zargos,

pour moi tout ceci me pose beaucoup de questions

pour commencer:

-1 comment?

Pourquoi (pour mettre un peu d’ordre dans mes idées ou pour des motifs plus techniques) ?

Il s’agit de 2 SSD et non de disques durs, les questions d’adjacence et de fin de disque restent-elles opportunes?

2- Ensuite, les RAID dont vous parlez sont-ils bien les LVM en miroir? (et là, les questions se multiplient…)

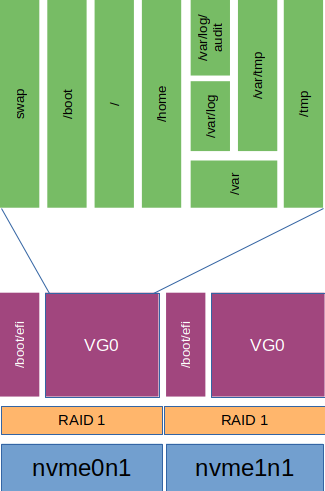

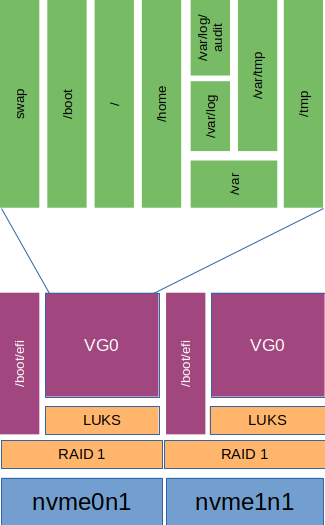

Le boot efi est bien sur une partition séparée, et j’ai créé une partition identique sur le 2e SSD pour y placer une copie

Mes données ne sont pas en Miroir LVM, mais l’espace sur le 2e SSD est prévu pour en faire régulièrement une copie.

(pour l’instant, les sauvegardes ne sont qu’externes)

En effet, je n’ai jamais eu d’autres soucis que ceux que j’ai créé moi-même, et non par problème de disque dur ou de SSD. Dans ce cas le LVM reproduit évidemment mes erreurs et autres imprudences. Bien entendu, je me doute que cela peut arriver, mais, pour mes données, je dispose déjà de sauvegardes fréquentes et incrémentales.